Universelle Plattform für Serviceroboter: Vom Konzept zur Anwendung

Projekt in Kürze: Das Promwad-Team hat einen Prototyp eines autonomen, KI-gesteuerten Serviceroboters entwickelt, der an die Bedürfnisse verschiedener Branchen angepasst werden kann, vom Hotel- und Gaststättengewerbe bis hin zu Medizin, Logistik und Bildung, und der Aufgaben wie die Auslieferung von Bestellungen, Hilfe bei der Navigation, den Transport von Waren und die Begleitung von Gästen übernimmt.

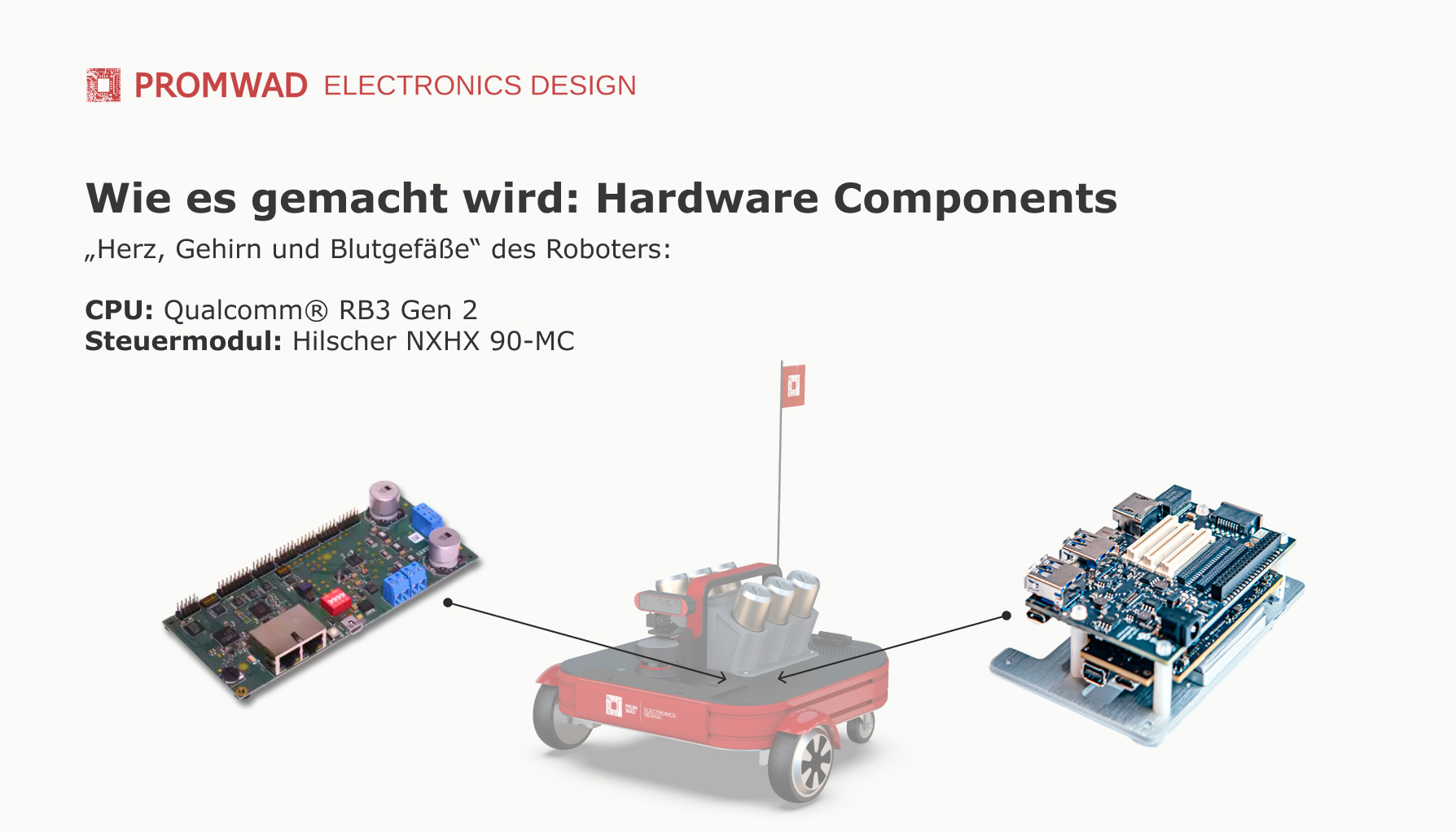

Diese anpassungsfähige Plattform basiert auf dem Qualcomm® RB3 Gen 2 Dev Kit und dem Hilscher NXHX 90-MC Dev Board, um eine sichere Navigation auch an überfüllten Orten zu gewährleisten. Neuronale Netze zur Objekterkennung sind in das System integriert: Sie ermöglichen es dem Roboter, Menschen genau von anderen Hindernissen zu unterscheiden. Die Plattform umfasst Sprachinteraktion, Kartensensoren und leistungsstarke Akkus, die für eine lange Betriebsdauer optimiert sind.

Herausforderung

Promwad hatte sich zum Ziel gesetzt, einen mobilen Roboter zu entwickeln, der den Besuchern von Tech-Events Getränke serviert und die Möglichkeiten unserer universellen Plattform für die Entwicklung kundenspezifischer Serviceroboter demonstriert.

Obwohl das Projekt nicht für die kommerzielle Nutzung gedacht ist, war es unser Ziel, eine nachhaltige und anpassungsfähige Plattform mit Navigations- und Steuerungssystemen und einem kompakten, leicht montierbaren Gehäuse zu schaffen.

1. Hardware-Entwurf

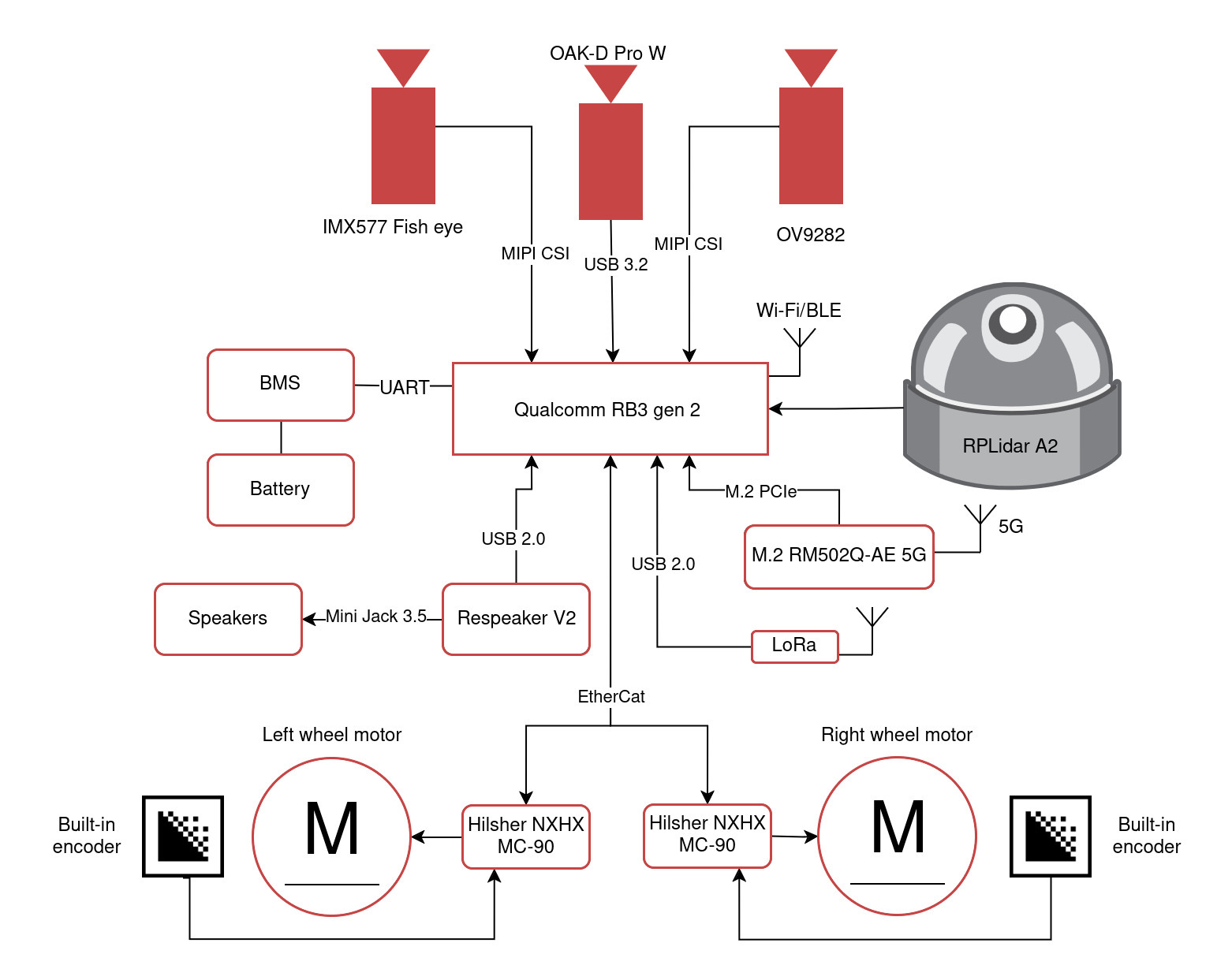

Die Hardware-Architektur des Roboters integriert verschiedene Sensor-, Kommunikations- und Steuerungskomponenten. Die zentrale Recheneinheit des Systems ist die Qualcomm® RB3 Gen 2 Plattform, in der alle Komponenten integriert sind.

Blockdiagramm der Hardware-Architektur: Qualcomm® RB3 Gen 2-Plattform und ihre integrierten Komponenten

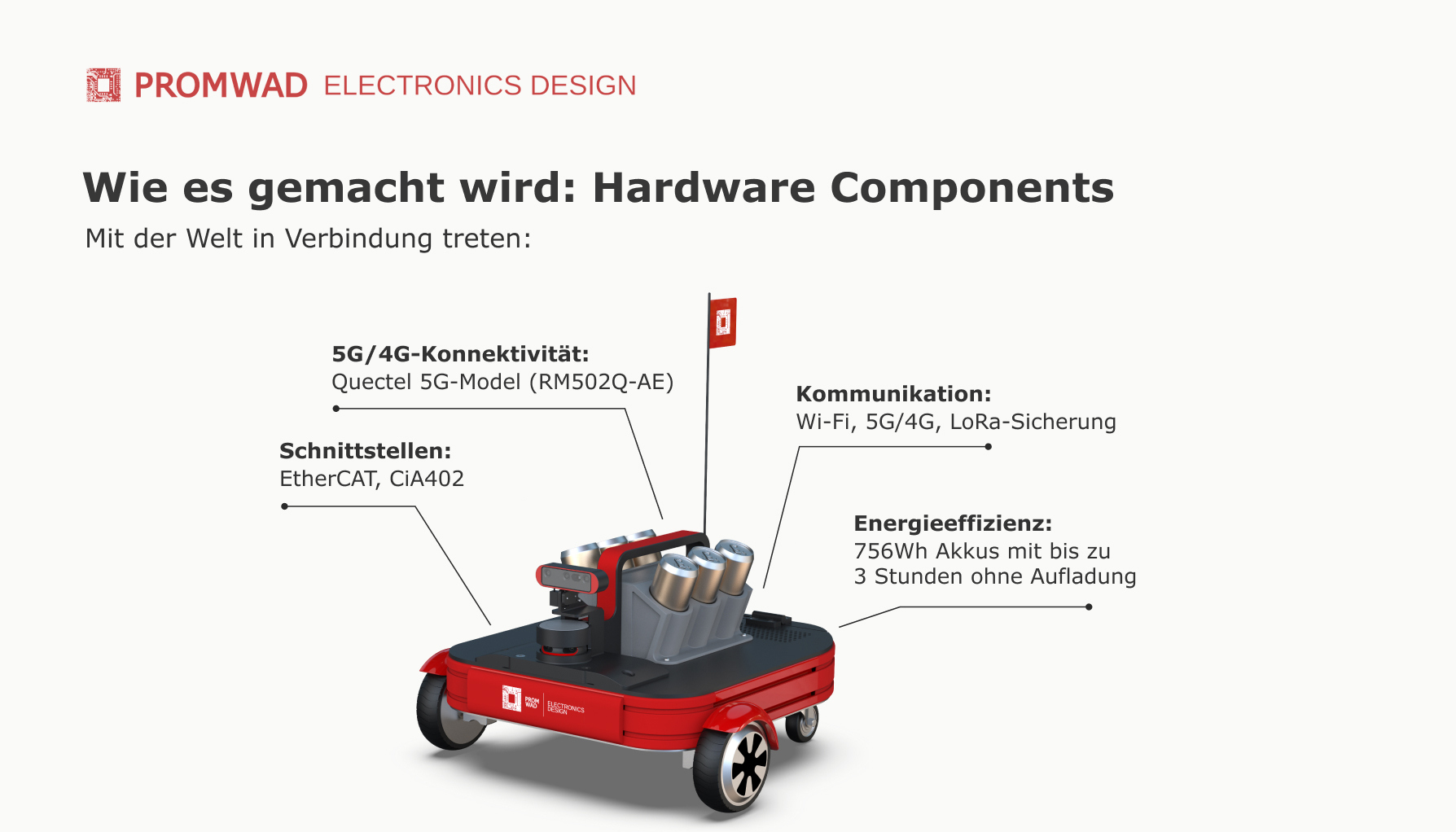

Die Qualcomm® RB3-Plattform bietet drahtlose Plattformkonnektivität über mehrere Kanäle:

- Wi-Fi: Grundlegende Konnektivität in Gebäuden.

- 5G/4G unterstützt durch das M.2 RM502Q-AE 5G-Modem über eine M.2 PCIe-Verbindung, die verwendet wird, wenn keine Wi-Fi-Abdeckung verfügbar ist.

- LoRa: Redundanter Kanal für Telemetrie und grundlegende Steuerung, der die Kommunikation in Gebieten mit geringer Abdeckung ermöglicht.

Navigation mit Lidar Mapping & Kameras für 360-View

Der RPLidar A2 ist der Hauptsensor für die Lokalisierung und Kartierung. Er ermöglicht eine 360-Grad-Laserabtastung, mit der der Roboter Hindernisse erkennen und 2D-Karten der Umgebung erstellen kann. Während dies für eine genaue Lokalisierung und Kartenaktualisierung unerlässlich ist, deckt das Sichtfeld des Lidars nicht etwa 90 Grad hinter dem Roboter ab: Wir haben diese Einschränkung mit Computer-Vision-Algorithmen unter Verwendung einer hinten montierten IMX577-Fischaugenkamera kompensiert.

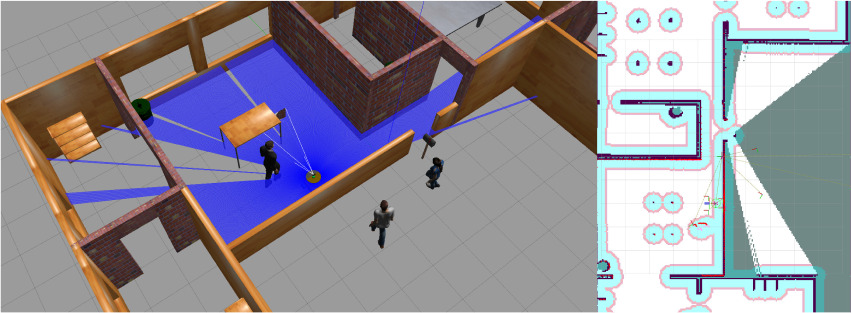

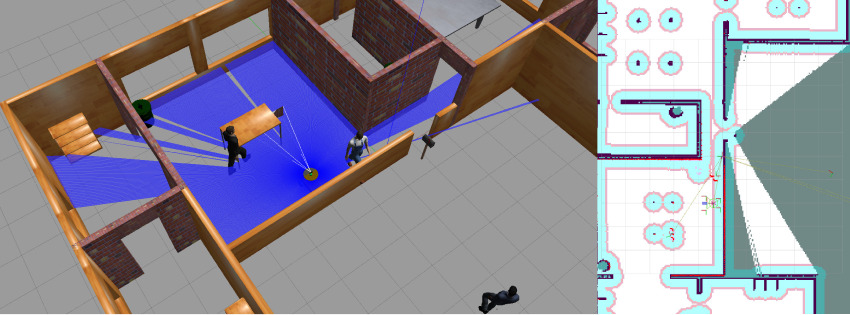

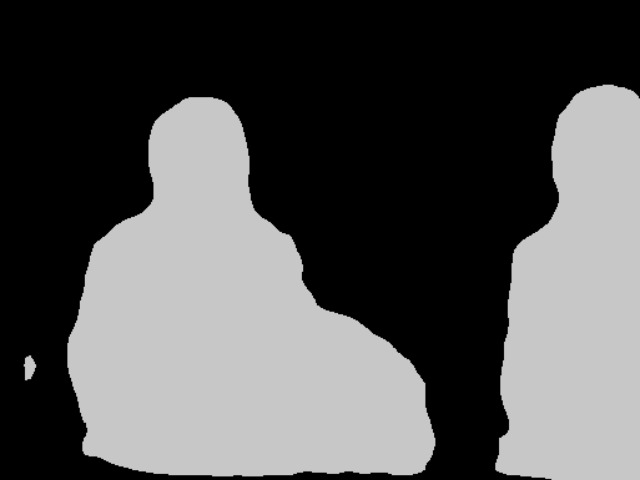

Das Erscheinungsbild der Robotersimulation mit der Menschensimulation und der Roboternavigationskarte zum gleichen Zeitpunkt. Eine Person befindet sich in der Sichtlinie des Roboters

Um die Navigationsgenauigkeit zu erhöhen, ist der Roboter zusätzlich mit den Kameras OAK-D Pro W und OV9282 ausgestattet. Die an der Vorderseite montierte Tiefenkamera OAK-D Pro W unterstützt die räumliche Orientierung und Navigation durch die Bereitstellung von Punktwolkendaten und die Erkennung von Personen für soziale Navigationsaufgaben. Die OV9282-Kamera wird für die Deckennavigation verwendet.

Robotersimulation und Navigationskarte, aber es befinden sich zwei Personen in der Sichtlinie des Roboters

Klangverarbeitung & Sprachsteuerung

Für die Klangverarbeitung haben wir das Modul Respeaker V2 mit ODAS (Open Embedded Audition System) integriert. Diese Lösung ermöglicht die Lokalisierung der Schallquelle und die Isolierung der spezifischen Sprache von den Hintergrundgeräuschen. Verschiedene Audio-Meldungen und Signale werden über die Lautsprecher übertragen.

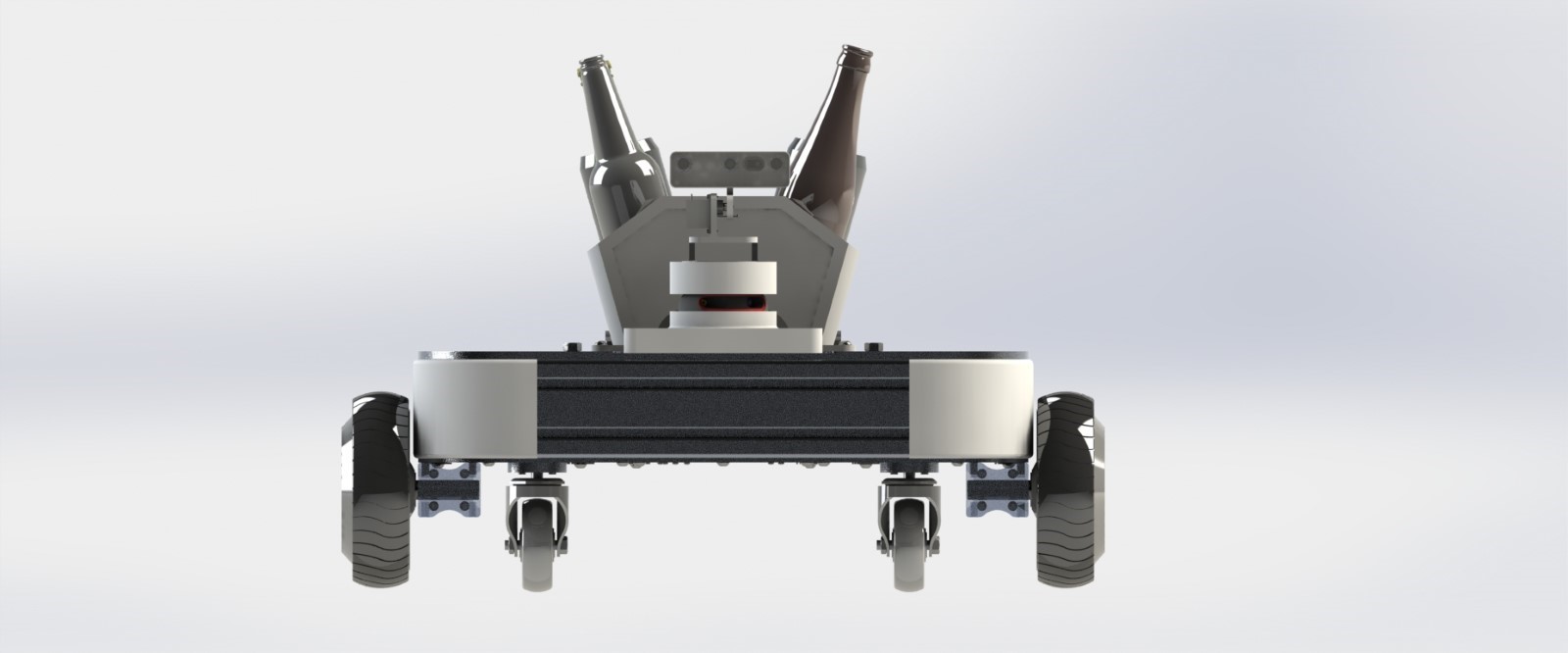

Unterwegs

Die Plattform verfügt über zwei leistungsstarke Parallax-Motor-Räder mit einem Durchmesser von 6,5' mit eingebauten Encodern und einer Leistung von je 250 W. Sie sorgen für Stabilität, Manövrierfähigkeit und schnelle Reaktion auf Befehle. Zwei passive Räder aus dem Heavy-Duty Caster Wheel Kit werden verwendet, um das Gleichgewicht zu halten und den Stromverbrauch zu minimieren.

Der Roboter hat zwei 6,5-Zoll-Motor-Räder für die Manövrierfähigkeit und zwei passive Räder für das Gleichgewicht und die Energieeffizienz

Die maximale Fahrgeschwindigkeit beträgt 10 m/s. Eigentlich kann die Plattform sogar noch höhere Werte erreichen, wird aber bewusst per Software begrenzt, um die Sicherheitsstandards bei öffentlichen Veranstaltungen zu erfüllen.

Die Motoren werden von der Hilscher NXHX 90-MC gesteuert, die die EtherCAT-Schnittstelle für eine schnelle und zuverlässige Datenübertragung und den CiA402-Standard für die Antriebssteuerung nutzt. Das Modul wird über eine ESI-Datei konfiguriert, was eine flexible Anpassung ermöglicht. Diese Architektur vereinfacht die Systemintegration, geringe Latenzzeiten, hohen Durchsatz und die Synchronisation aller Komponenten. Das Steuerungsprofil unterstützt drei Hauptmodi:

- Positionierung;

- Geschwindigkeitsmodus;

- Drehmomentsteuerung.

Akku und Energieverwaltung

Das Power-Management-Subsystem umfasst eine 350-Wh-10S3P-Batterie mit einem UART-verbundenen Batteriemanagementsystem, das 1,5 Stunden Betrieb bei voller Leistung ermöglicht. In realen Anwendungen kann diese Zeit auf drei Stunden verlängert werden. Eine vollständige Aufladung dauert 4,2 Stunden.

2. Software-Entwicklung

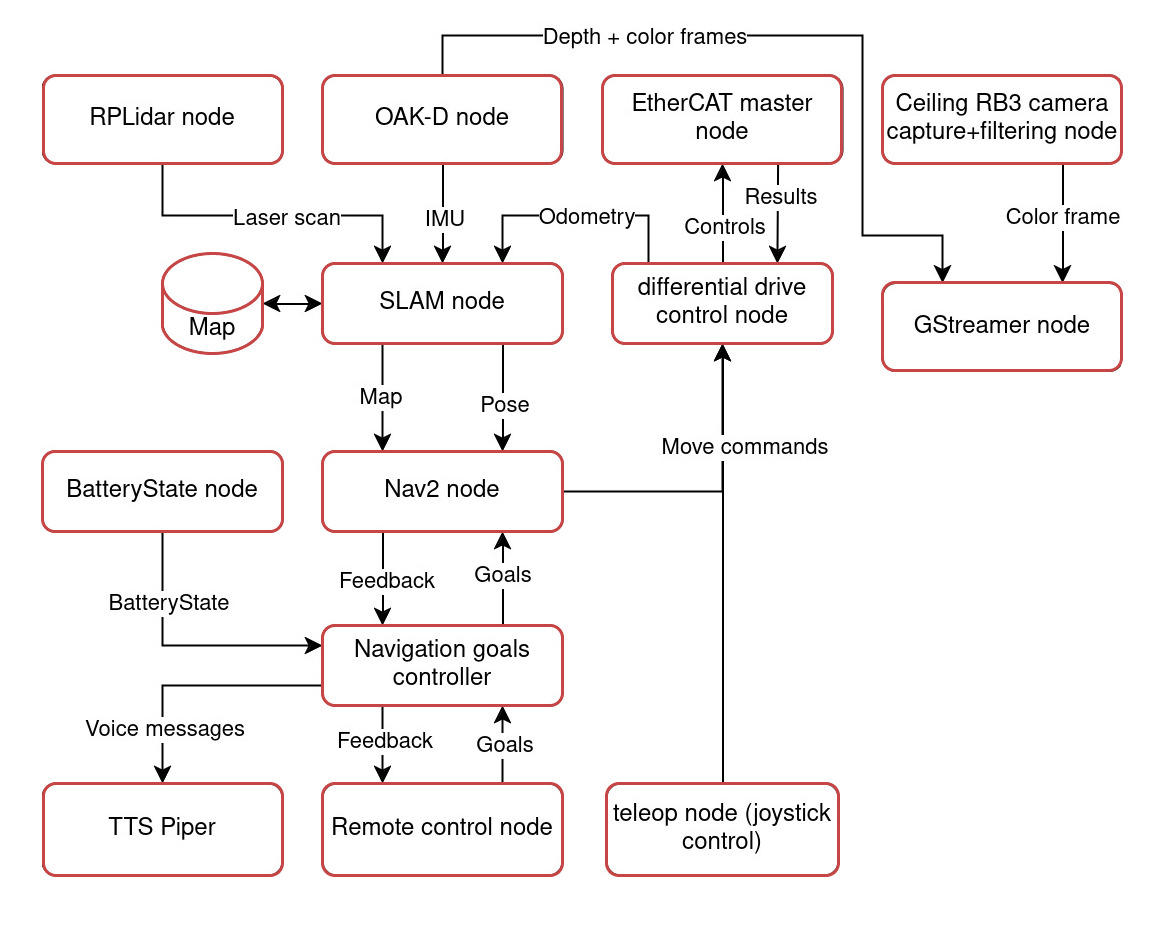

Die Roboterplattform ist mit allen Softwareebenen ausgestattet, die für die volle Funktionsfähigkeit erforderlich sind, und verfügt über alle wesentlichen Module für spezifische Aufgaben, darunter:

- Fernsteuerungsknoten.

- Sensorknoten für Lidar und Kameras.

- EtherCAT-Master-Knoten für die Steuerung von EtherCAT-Netzwerken.

- BatteryState-Knoten für die Überwachung des Batteriestatus des Roboters.

- SLAM-Knoten für Lokalisierung und Kartenerstellung (SLAM).

- Nav2-Knoten für die Bahnplanung und Roboternavigation.

- Differential Drive Control-Knoten empfängt Befehle von Nav2 oder Teleop und wandelt sie in Befehle für die Motoren um, so dass sich der Roboter auf vorgegebenen Bahnen bewegen kann.

- Navigationszielsteuerung für die Steuerung der Navigationsziele des Roboters.

- Teleop-Knoten für die manuelle Bedienung mit einem Joystick.

- GStreamer für die Übertragung von Videodaten von Kameras.

- Text-to-Speech (TTS) Piper zur Erzeugung von Sprache aus Textnachrichten.

- Gazebo für die physikalische Simulation des Roboters und seiner Interaktion mit der Umgebung.

- HuNavSim zur Simulation des menschlichen Verhaltens, um eine realistischere Umgebung für das Testen von Navigationsalgorithmen zu schaffen.

Blockdiagramm der ROS2-Projektknoten

3. Training des neuronalen Modells

Da der Roboter in belebten Umgebungen operieren wird, ist eine genaue Erkennung von Hindernissen und die Berücksichtigung ihrer Bewegungen für seine sichere und korrekte Navigation erforderlich.

Lidar-Daten können nicht die einzige Quelle für Navigationsinformationen sein, da die Anwesenheit und die Bewegung von Menschen erhebliche Fehler in den Berechnungen verursachen. Um dieses Problem zu lösen, haben wir eine Technik entwickelt, um Lidar-Punkte, die mit Personen in Verbindung stehen, durch deren Erkennung auszuschließen. Wir wendeten die semantische Segmentierung an, eine Computer-Vision-Technik, bei der jedes Pixel eines Bildes einer bestimmten Klasse (in unserem Fall „Mensch“) zugeordnet wird, und verwendeten eine binäre Maske, um Menschen von anderen Objekten zu trennen.

Im Bild links ist das Originalfoto zu sehen, und rechts die so genannte Segmentierungsmaske, bei der alle Pixel, die zur Klasse „Mensch“ gehören, eine graue Farbe haben, um den Hintergrund abzugrenzen. Während des Trainings betrachtet das Modell wiederholt solche Paare (Original + Maske) und passt seine Algorithmen an, um jedes Mal genauer zu bestimmen, welche Pixel zu Menschen gehören.

Bildsegmentierung mit dem neuronalen Modell DeepLabv3. Quelle: cocodataset.org

Für die Bildsegmentierung haben wir das DeepLabv3-Modell gewählt, das auf der MobileNet-Architektur basiert. Sein Hauptmerkmal sind erweiterte Faltungen, die das rezeptive Feld des Modells für eine genaue Segmentierung vergrößern.

Wir trainierten das Modell mit einem Teil des COCO-Bilddatensatzes mit Personen. Die Trainingsstichprobe bestand aus mehr als 50 Tausend Bildern und die Validierungsstichprobe aus mehr als 2,5 Tausend Bildern.

Zur Bewertung der Qualität wurde die Metrik Intersection over Union (IoU) verwendet, die angibt, wie stark sich die vorhergesagten und die kommentierten Masken überschneiden und übereinstimmen. Bei der Validierung erreichte das Modell einen IoU-Wert von über 90 %.

Die Gewichte wurden nach dem Training quantifiziert, um das Modell auf dem Qualcomm® RB3-Gerät zu optimieren. Dadurch wurde der Speicherbedarf reduziert und die Modellleistung verbessert, was eine stabile und genaue Segmentierung unter realen Bedingungen gewährleistet.

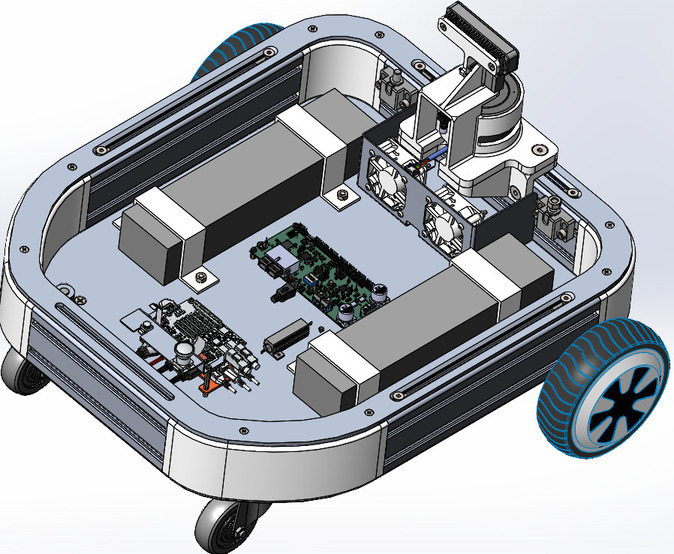

4. Gehäuse und mechanische Konstruktion

Die mechanische Konstruktion des Roboters besteht aus einem robusten Aluminiumprofil mit lasergeschnittenen und 3D-gedruckten Teilen, die eine einfache Montage ermöglichen und den Einsatz von Spezialwerkzeugen überflüssig machen.

Eine Basis des Roboterkörpers mit wichtigen Steuerungskomponenten

Der Sockel des Robotergehäuses enthält die Steuerelemente:

- ein Bildverarbeitungsmodul;

- ein lidar;

- ein Mikrofon;

- Batterien;

- Lüfter;

- das Qualcomm® RB3 Gen 2 Entwicklungskit;

- das Hilscher NXHX 90-MC Entwicklungskit.

Geschäftlicher Wert

Die anpassungsfähige Robotikplattform ermöglicht unseren Kunden einen effizienten Einstieg in den Markt der Servicerobotik. Mit einer Standardlösung können sie Entwicklungszeit und -kosten reduzieren und gleichzeitig ihr Design an die spezifischen Anforderungen verschiedener Branchen anpassen: Gastgewerbe, Lagerhaltung, Gesundheitswesen usw.

Die ausgefeilten Funktionen der Plattform für Navigation, Hindernisvermeidung und Menschenkenntnis machen sie ideal für Umgebungen, die einen sicheren und autonomen Service erfordern.

Mehr von dem, was wir für die Robotik tun

- Robotik-Engineering: Entdecken Sie unsere Robotik-Entwicklungsdienste für eine Vielzahl von Anwendungen.

- Nvidia-Robotikplattform mit Industrieprotokollen: eine Fallstudie über die Entwicklung einer einzigartigen Plattform mit Unterstützung für gängige industrielle Netzwerkprotokolle.

- SRCI mit PROFINET: Sehen Sie sich unsere Studie über die SRCI-Schnittstelle für die Robotersteuerung mit SPSen verschiedener Hersteller an.